这是一篇关于 Similarity of Neural Network Representations Revisited 的笔记.

Setup

$X \in \mathbb{R}^{n \times p_{1}}$, $Y \in \mathbb{R}^{n \times p_{2}}$ 是两个激活矩阵. $n$ 是样本数, $p_{1}$ 和 $p_{2}$ 分别是两个激活矩阵的维度. 不是一般性, 我们假设 $p_{1} \leq p_{2}$. 我们希望找到一个指标 $s(X, Y)$ 来衡量两个激活矩阵之间的相似性.

该研究认为, 相似性的直观概念和神经网络训练的动态过程都要求 $s$ 满足对正交变换和满足对各向同性缩放是不变的, 而非对可逆线性变换的不变.

可逆线性变换不变性

可逆线性变换不变性

对于任意满秩矩阵 $A$, $B$, 如果 $s(X, Y) = s(XA, YB)$, 那么就称 $s(X, Y)$ 满足可逆线性变换不变性.

Theorem 1

设 $X, Y \in \mathbb{R}^{n \times p}$, 对任意 $Z$ 和秩为 $p$ 的矩阵 $A$:

可逆线性变换可变性的局限性:

文章指出,对可逆线性变换不变的任何相似性指数在表示的维度大于数据点数量时会遇到问题。具体来说,这样的指数对于宽度(即神经元数量)大于或等于数据集大小的任何表示都会给出相同的结果。这在实际应用中可能不是特别有用,因为在深度学习中,很多时候层的宽度会超过样本数量。

具体来说, 可逆线性变换不变性会导致关键信息的损失, 如: 方向的缩放, 欧氏距离的一致性.

正交变换不变性

正交变换不变性

对于任意正交矩阵 $U$, $V$ ($U^{T}U=V^{T}V=I$), 如果 $s(X, Y) = s(XU, YV)$, 那么就称 $s(X, Y)$ 满足可逆线性变换不变性.

正交变换不变性是一个比可逆线性变换不变性更弱的条件. 两者在几何结构方面的对比如下:

可逆线性变换不变性

包括旋转, 对称等正交变换;

保持了数据的线性属性不变, 但几何结构可能会变.

正交变换不变性

包括旋转, 对称等正交变换;

保持了数据的几何结构 (标量积, 欧式距离等) 不变.

各向同性缩放不变性

正交变换不变性

对于任意 $\alpha ,\beta \in \mathbb{R}^{+}$, 如果 $s(X, Y) = s(\alpha X, \beta Y)$, 那么就称 $s(X, Y)$ 满足可逆各向同性缩放不变性.

注意到:

由矩阵奇异值的存在性得到:

正交变化不变性 $+$ 非各向同性缩放不变性 (各个特征值的重新缩放) $=$ 可逆线性变换不变性.

Centered Kernel Alignment (CKA)

我们已经了解了 HSIC :

其中 $K, L$ 是两个核矩阵, $H$ 是中心矩阵.

注意到, HSIC 并不满足可逆线性变换, 故我们将其归一化, 得到 CKA:

以下是两个常见的核矩阵的 CKA:

- 线性核 $K_{X}(x_{1}, x_{2}) = x_{1}^{T}x_{2}$

- RBF 核 $K_{X}(x_{1}, x_{2}) = \exp(-\lVert x_{1} - x_{2} \rVert^{2} / 2\sigma^{2})$

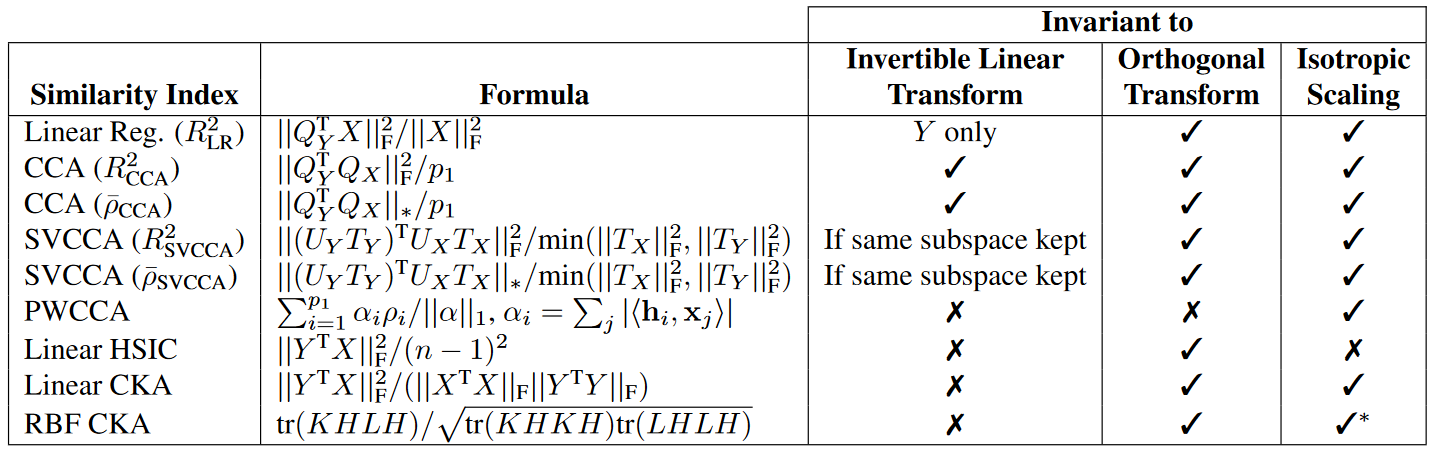

Related Similarity Indexes

记 $Q_{X}, Q_{Y}$ 是 $X, Y$ 的一组标准正交基, 我们可以得到以下几种相似性度量, 它们的公式和性质如下:

Linear Ridgelet

为了刻画 $Q_{X}$ 和 $Q_{X}$ 之间的相关性, 一个 Naive 的方式是尝试用 Y 的线性组合来表出 X, 并最大化相关系数. 于是有了以下基于线性回归的度量:

Canonical Correlation Analysis (CCA)

CCA 试图用通过最大化 $X$ 的线性组合和 $Y$ 的线性组合之间的相关系数来衡量两个矩阵之间的相关性. 具体来说, CCA 通过以下方式来定义一组相关系数 $\rho_{1}, \cdots \rho_{p_{1}}$:

基于以上定义, 我们可以得到以下两种 CCA 的度量方式:

其中 $\lVert \cdot \rVert_{F}$ 和 $\lVert \cdot \rVert_{*}$ 分别是 Frobenius 范数和核范数.

Singular Value CCA (SVCCA)

CCA 对扰动敏感, 为了提高 CCA 的鲁棒性, SVCCA 通过对 X 和 Y 的截断奇异值分解进行 CCA, 从而得到了一个更稳定的度量方式:

其中 $U_{X}, U_{Y}$ 是 $X, Y$ 的左奇异矩阵, $m$ 是截断数, $T_{X}, T_{Y}$ 是 $X, Y$ 的截断单位矩阵, 用来选择左奇异向量.

Projection Weighted CCA (PWCCA)

另一种提高 CCA 鲁棒性的方式是 PWCCA. PWCCA 注意到 占原始输出比重较大的CCA vector $\rho^{i}$ 对于潜在的representation更重要. 故相比于 SVCCA 直接取算数平均, PWCCA 通过给每一个 $\rho^{i}$ 添加权重 $\alpha^{i}$ 来计算加权平均值:

基于 $\rho_{PWCCA}$, 我们可以得到 PWCCA 的度量方式: